O interesse em saber se as máquinas poderiam reproduzir o raciocínio humano e dialogar com as pessoas faz parte da história da computação.

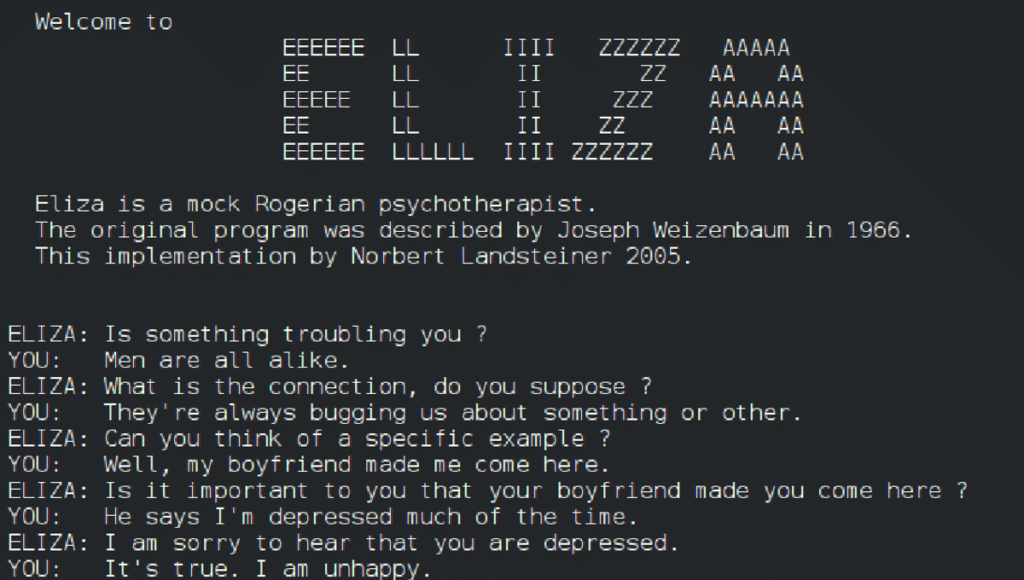

Eliza, o primeiro robô de conversação, do inglês “chatbot”, foi criada pelo matemático Joseph Weizenbaum, pesquisador do Instituto de Tecnologia de Massachusetts (MIT), para funcionar como uma espécie de psicóloga virtual, em 1965, bem antes da popularização do computador pessoal, na década de 1980.

Na prática, Weizenbaum criou um software capaz de identificar 250 tipos de frases e enganar o interlocutor usando trechos das perguntas em suas respostas.

“A Eliza usava uma série de truques para parecer que era inteligente e o usuário se esquecia de que estava conversando com um computador”, lembra o engenheiro elétrico e administrador Rodrigo Siqueira, fundador da empresa Inbot onde desenvolve chatbots com processamento de linguagem natural desde 2001 para empresas.

O mecanismo de identificação de palavras-chave usado pela “mãe dos chatbots” ainda é aplicado nos robôs de conversação mais simples, que foram evoluindo com camadas adicionais de programação passando a compreender erros ortográficos, mudanças de sintaxe e semântica, por exemplo.

“Fomos refinando estes mecanismos para entender a intenção do usuário e formulando vários tipos de respostas para identificar aquela com a maior chance de ser a resposta correta”, explica o pesquisador de algoritmos de Inteligência Artificial e aprendizado de máquina.

O ChatGPT foi além e até consegue identificar os sentimentos do interlocutor e, assim, convencê-lo de que é inteligente. “A IA generativa consegue entender que o consumidor precisa da segunda via da fatura porque o cachorro comeu o boleto, coisa que um chatbot comum não entenderia”, compara Siqueira. A desvantagem, no entanto, “é não se ter certeza sobre qual será a resposta”, alerta.

A aparente confiabilidade demonstrada pelo ChatGPT ao elaborar informações falsas de forma convincente – algo que a OpenAI prometeu mitigar na versão 4.0, recentemente – é uma barreira considerável para a aplicação da inteligência artificial generativa nos negócios.

“A alucinação da IA é um dos maiores problemas”, nota o pesquisador. “Em alguns momentos é possível receber respostas convincentes e assertivas sobre linhas de produtos que não existem ou ter informações de preços que não são reais”, pondera o fundador da Inbot.

Treinar a ferramenta para reconhecer que não tem determinada resposta é uma alternativa testada pela Inbot para driblar a alucinação do ChatGPT em aplicações de negócios.

“Conseguimos fazer um treinamento adicional, inserindo uma programação para que ele diga que ‘não sabe’ caso não tenha a resposta”, afirma Siqueira, referindo-se ao programa de interface do ChatGPT usado na Inbot.